Il est toujours mal aisé de parler de prédiction économique voir même

simplement de modélisation tant le monde réel est compliqué. Ici je

présente trois petit modèle très simple avec chaque fois un petit

théorème. On peut plutôt parler de «fables» : des histoires très simplistes

qui illustre le propos plutôt qu'une argumentation et avec peut-être

une morale à fin.

L'algorithme hongrois, un argument neo-liberal ?

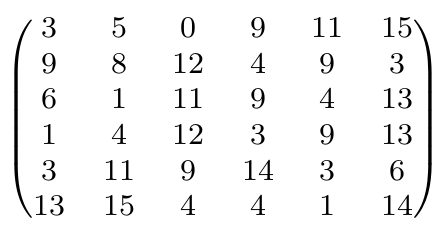

Considérons un tableau N par N avec des entrées positives et choisissons

N cases de telle sorte qu'il y en ait exactement une sur chaque ligne

et chaque colonne. Comment trouver la configuration qui minimise la

somme des cases choisies ? Il y a plusieurs illustrations/motivation

à ce problème. Par exemple, on peut penser à un ensemble de travailleurs

ayant des compétences différentes et une liste de taches à réaliser.

On aimerait alors donner une répartition des taches qui correspond

au mieux les compétences des travailleurs.

\[

\text{Exemple : }\left(\begin{array}{cccc}

1 & 4 & \boxed{2} & 3\\

\boxed{1} & 5 & 6 & 4\\

7 & \boxed{2} & 2 & 1\\

3 & 4 & 3 & \boxed{1}

\end{array}\right)\quad\text{Somme minimale}=6.

\]

Bien sur il est possible ici de tester toutes les possibilités mais

ce nomble devient vite trop important lorsque le tableau est un peu

grand. Le but du jeu est donc de trouver un algorithme efficace. L'idée

de l'algorithme hongrois repose sur les deux observations suivantes:

- Si il est possible de choisir une configuration uniquement avec des

cases de valeur nulle alors c'est terminé et le cout total est nul.

- Si on modifie le tableau en ajoutant une même valeur sur toute une

ligne ou sur tout une colonne alors on obtient un problème équivalent

\[

c(x,y)\rightarrow c(x,y)+P(x)+Q(y)

\]

En effet cela revient à ajouter une constante au cout total et on

ne modifie donc en rien le problème de minimisation : la configuration

minimale reste la même.

Le principe de l'algorithme est d'ajuster ces valeurs \(P\) et \(Q\)

de manière itérative de telle sorte à obtenir suffisamment de zéro

dans le tableau pour se retrouver le premier cas. Sans entrer dans

le détail des différentes étapes de l'algorithme voici juste faire

quelques remarques. Ce qui rend l'algorithme intéressant d'un point

de vue de l'économie est qu'il semble assez similaire au mécanisme

de l'offre et la demande avec une fluctuation des prix. Chaque travailleur

(=ligne) commence par postuler pour la(-es) taches qui lui conviendrait

le mieux et de même pour chaque tache (ligne) une proposition est

envoyée au(x) travailleur(s) le mieux qualifié pour la tache. Ensuite

si un travailleur reçoit plusieurs propositions il augmente légèrement

ses tarifs et inversement il les diminue si il ne voit proposer aucune

tache. (=augmenter ou diminuer toute une ligne) De même on augmente

ou diminue de prix pour une tache si elle est très demandée ou si

au contraire ne trouve pas de travailleurs (=augmenter ou diminuer

toute une colonne). Au bout d'un certain temps, on aboutit à une situation

où chaque travailleur a bien une tache associée.

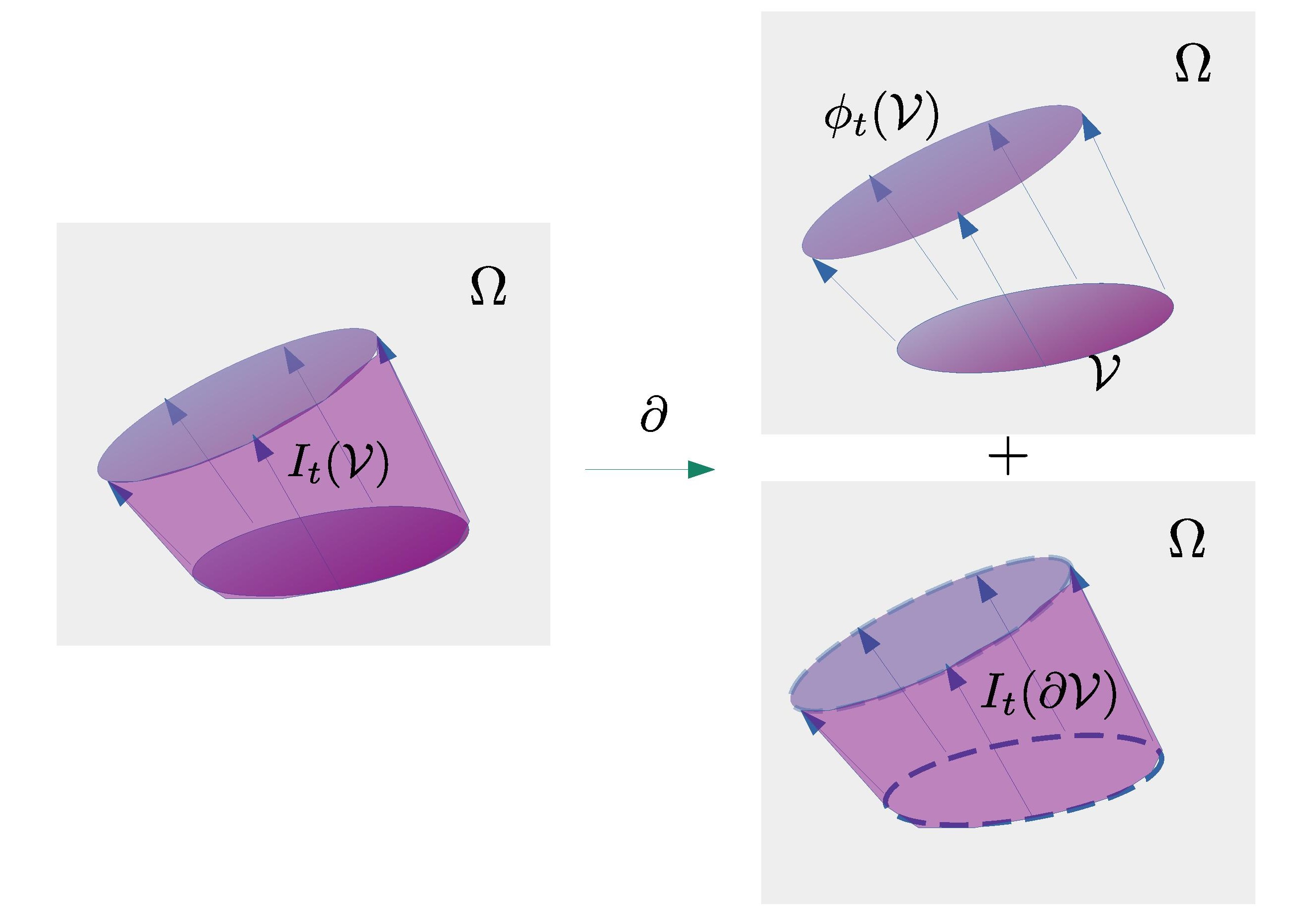

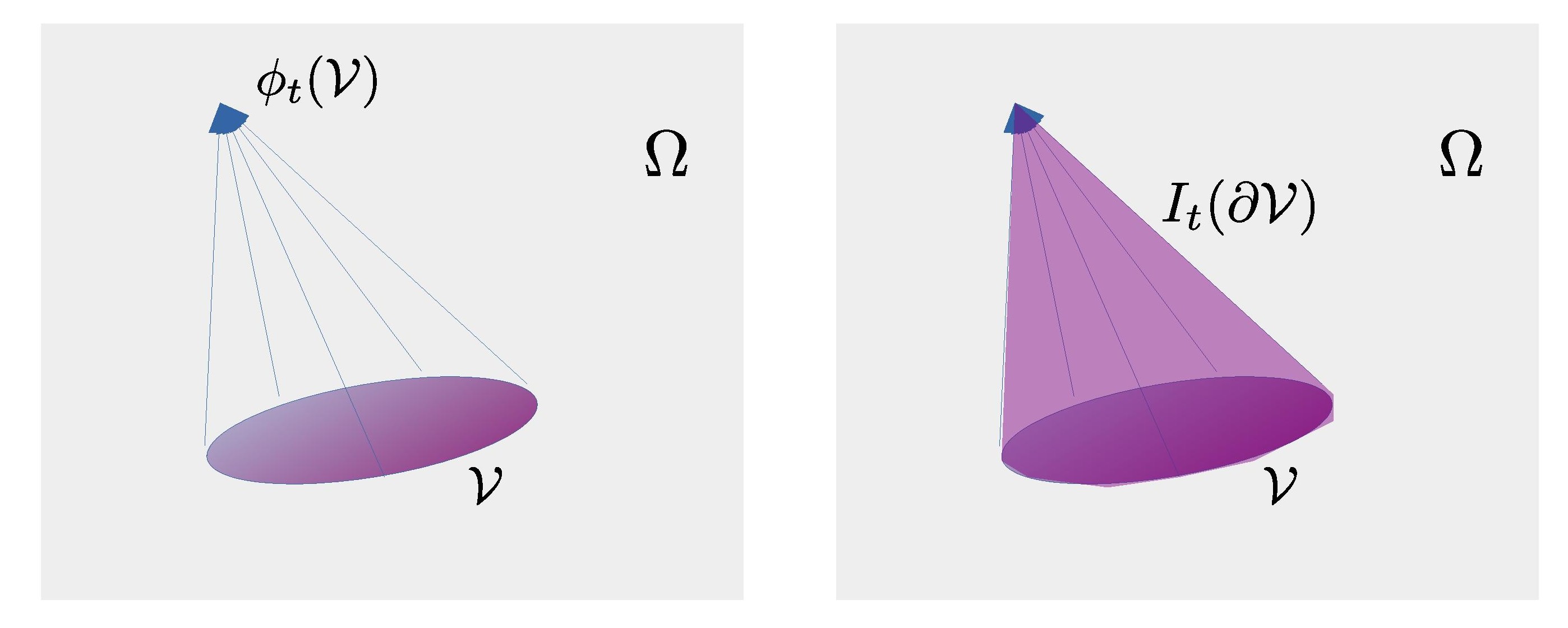

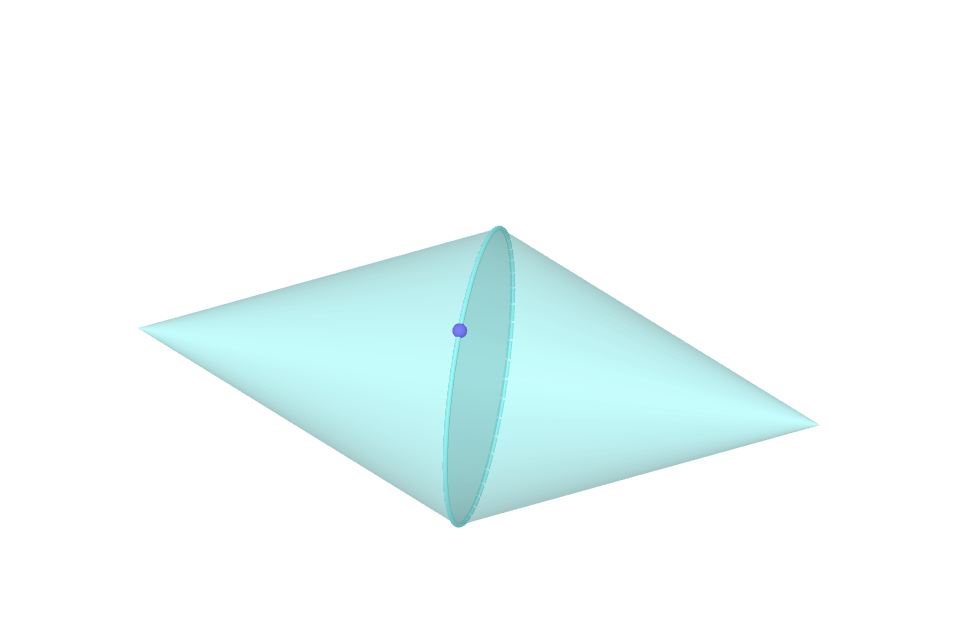

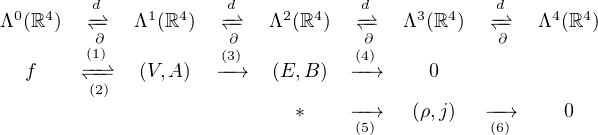

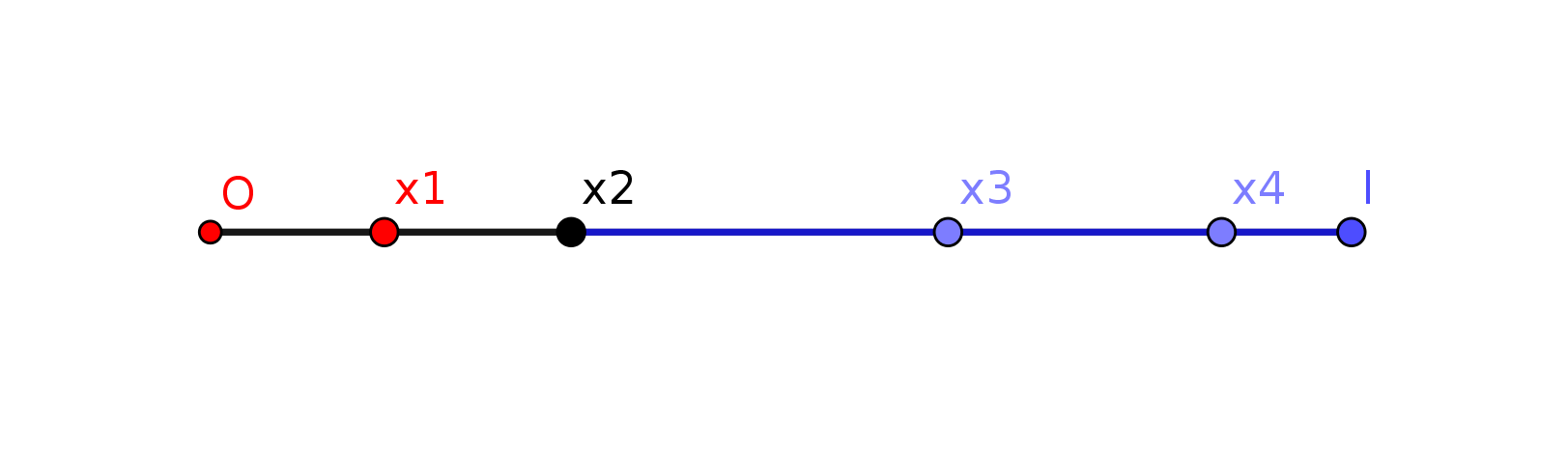

Assouplir le problème

On peut s'intéresser à une variante ``plus souple'' du problème

où on ne suppose pas que la répartion soit purement 0 ou 1 mais peut

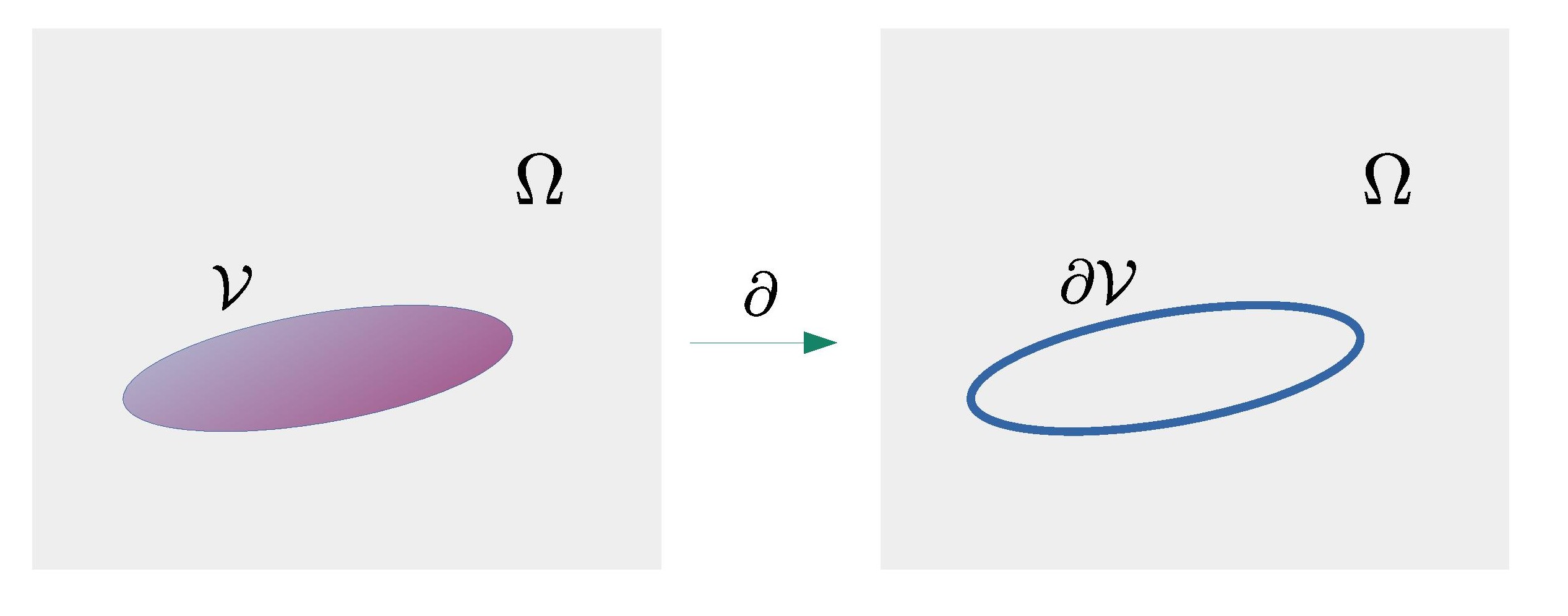

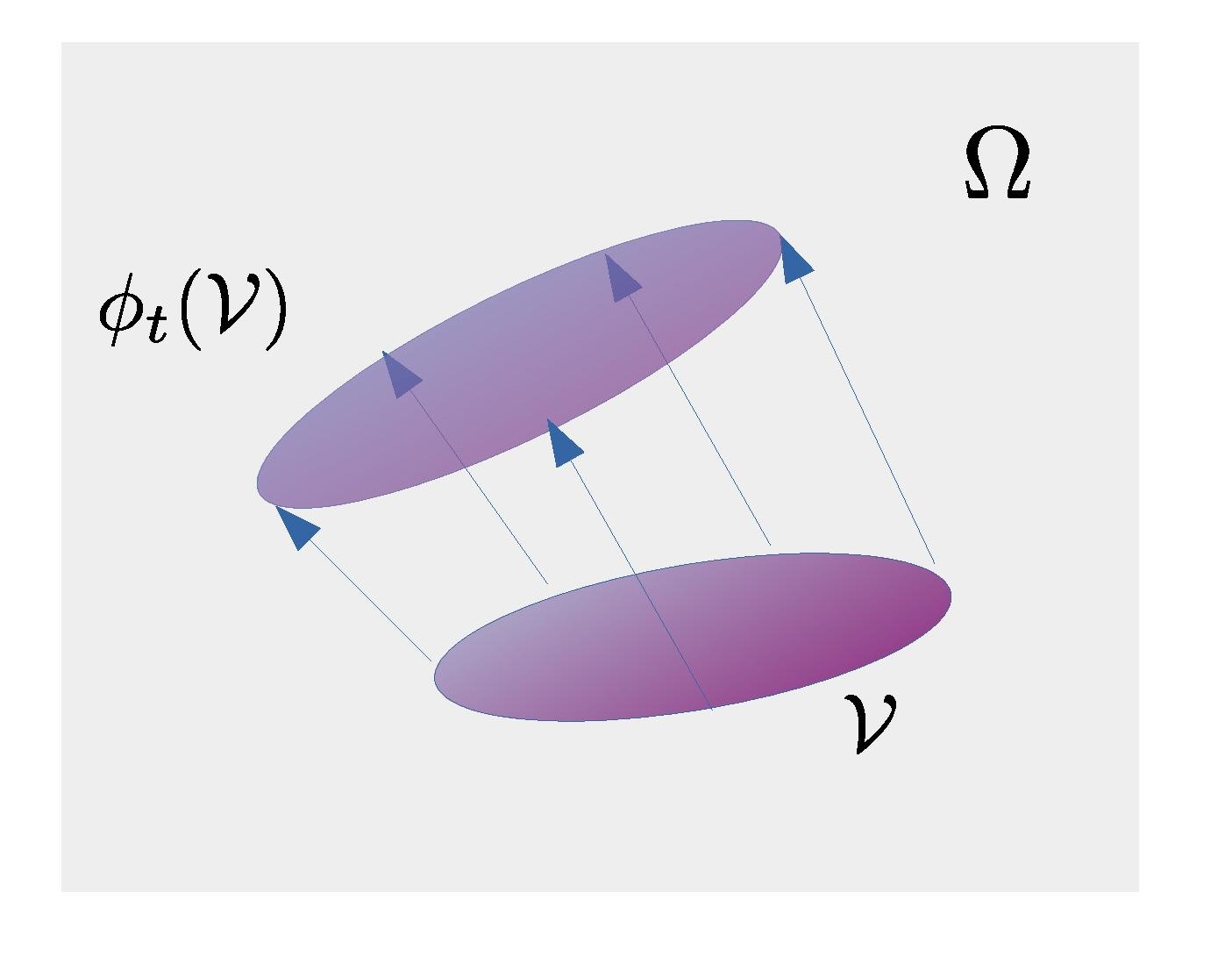

avoir une distribution continue. Formellement on a deux ensembles

fini \(E,F\) et deux distributions \((\mu(x))_{x\in E}\) et \((\nu(y))_{y\in F}\)

avec \(\sum_{x\in E}\mu(x)=\sum_{y\in F}\nu(y)\). On cherche à minimiser

parmi toutes les distribution \(\pi\) sur \(E\times F\) le cout total

donné par

\[

C(\pi):=\sum_{x,y}\pi(x,y)c(x,y)\qquad\sum_{y\in E}\pi(x,y)=\mu(x),\sum_{x\in F}\pi(x,y)=\nu(y).

\]

Il s'agit ici d'un problème très classique qui a même plus ou moins

créé tout le domaine de recherche du transport optimal. Comme exemple

de motivation Il s'agit de transporter une certaine quantité de matière

première initialement répartie dans différents entrepots qu'il faut

transporter vers différentes usines. Ici \(\pi(x,y)\) représente la

quantité de matière transportée de \(x\) à \(y\) et \(c(x,y)\) represente

le cout unitaire pour ce trajet.

L'astuce ici est de relacher la condition sur \(\pi\) que toutes les

et de la remplacer par une pénalité de paramètre \(\lambda\)

\[

C(\lambda,\pi)=\sum_{x,y\in E}c(x,y)\pi(x,y)+\frac{\lambda}{2}(\sum_{x\in E}(\sum_{y\in E}\pi(x,y)-\mu(x))^{2}+\sum_{y}(\sum_{x\in E}\pi(x,y)-\nu(y)){}^{2})

\]

Si la pénalité est suffisament grande on retrouve le problème initiale

\[

\inf_{\pi\in{\cal T}}C(\pi)=\lim_{\lambda\rightarrow\infty}\inf_{\pi\geq0}C(\lambda,\pi)

\]

L'intéret cependant est que ce problème est plus facile à résoudre.

On écrit la jacobienne

\[

j(x,y)=\frac{\partial C(\lambda,\pi)}{\partial\pi(x,y)}=c(x,y)+\lambda(\sum_{z\in E}\pi(x,z)-\mu(x)+\sum_{z\in E}\pi(z,y)-\nu(y))

\]

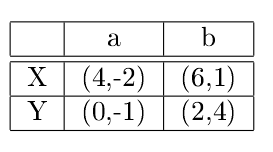

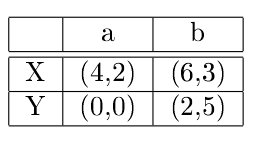

et on a bien ici les 2 points de l'algorithmes hongrois :

- la répartition qui minimise \(C(\lambda,\pi)\) ne remplit que les cases

telles que \(j(x,y)=0\)

- \(j(x,y)=c(x,y)+P(x)+Q(y).\)

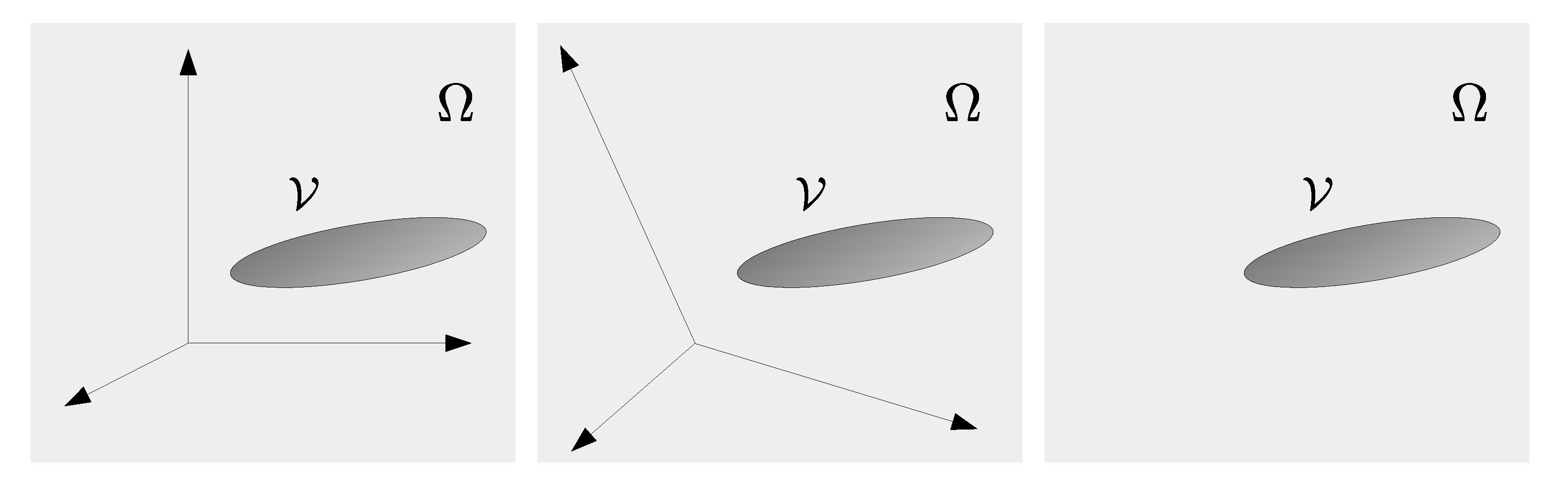

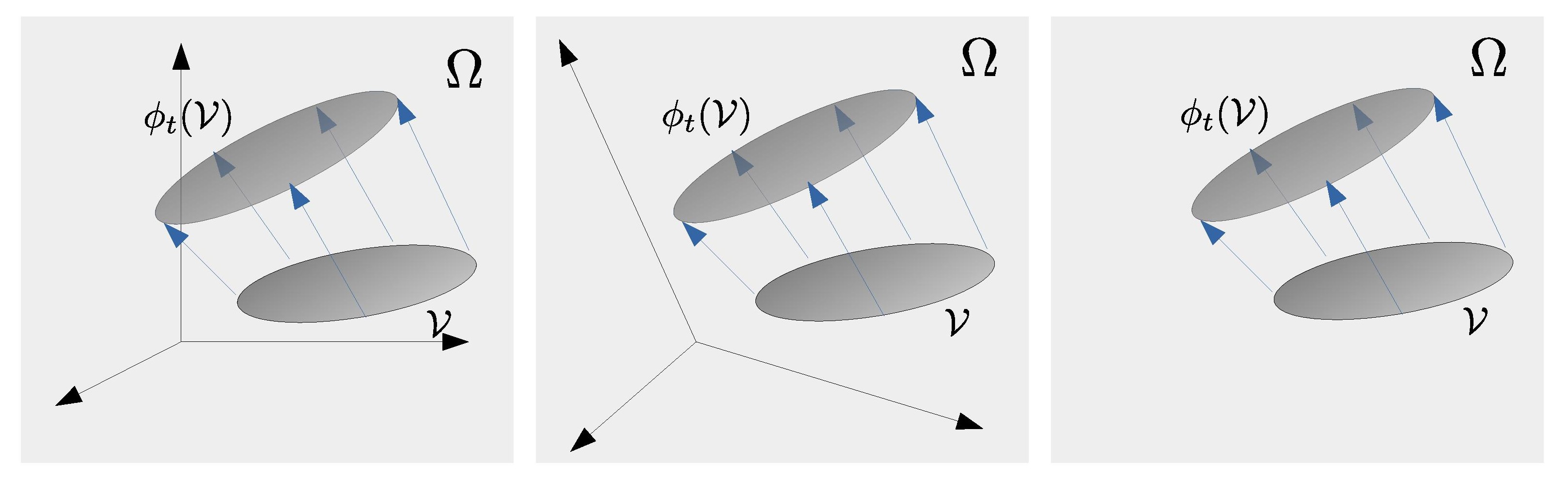

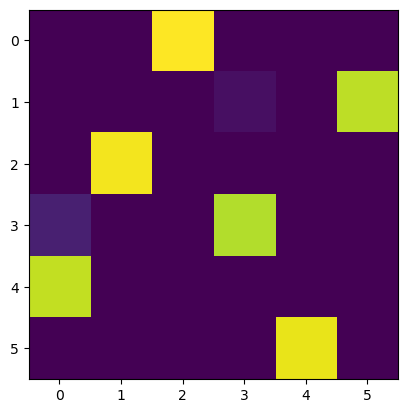

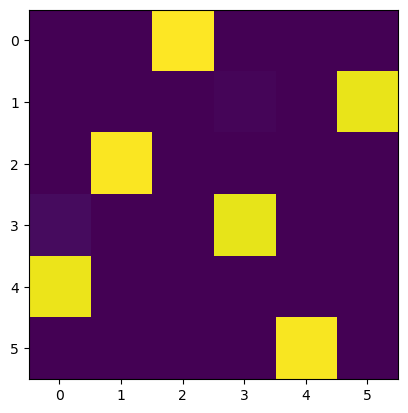

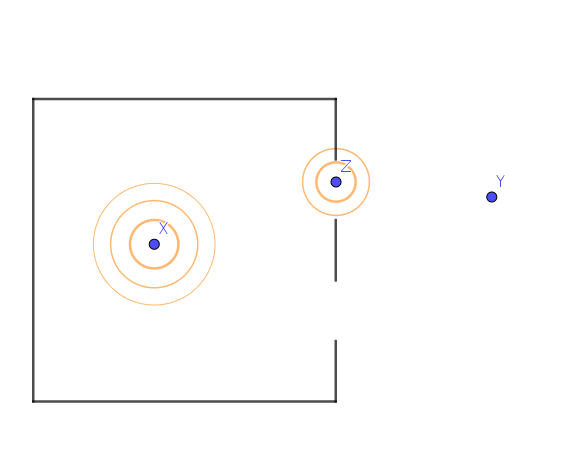

le tableau \(c\) et la distribution minimisant \(C(\lambda,\pi)\) pour

\(\lambda=10,30\) et \(90\).

\par\end{center}

Le message de ce post est le suivant : il semble que d'une certaine

manière cet algorithme est mis en pratique tous les jours de manière

inconciente et que l'organisation de la société dans son ensemble

repose en grande partie sur lui. Il faut reconnaitre que celui ci

est assez remarquable : à la fois très simple, efficace et décentralisé.

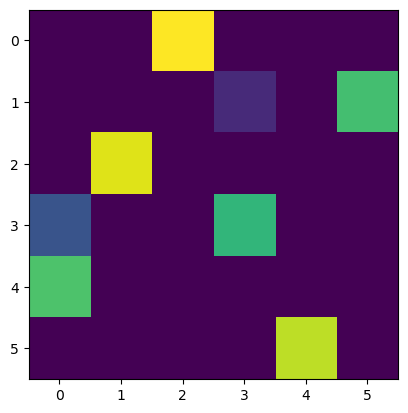

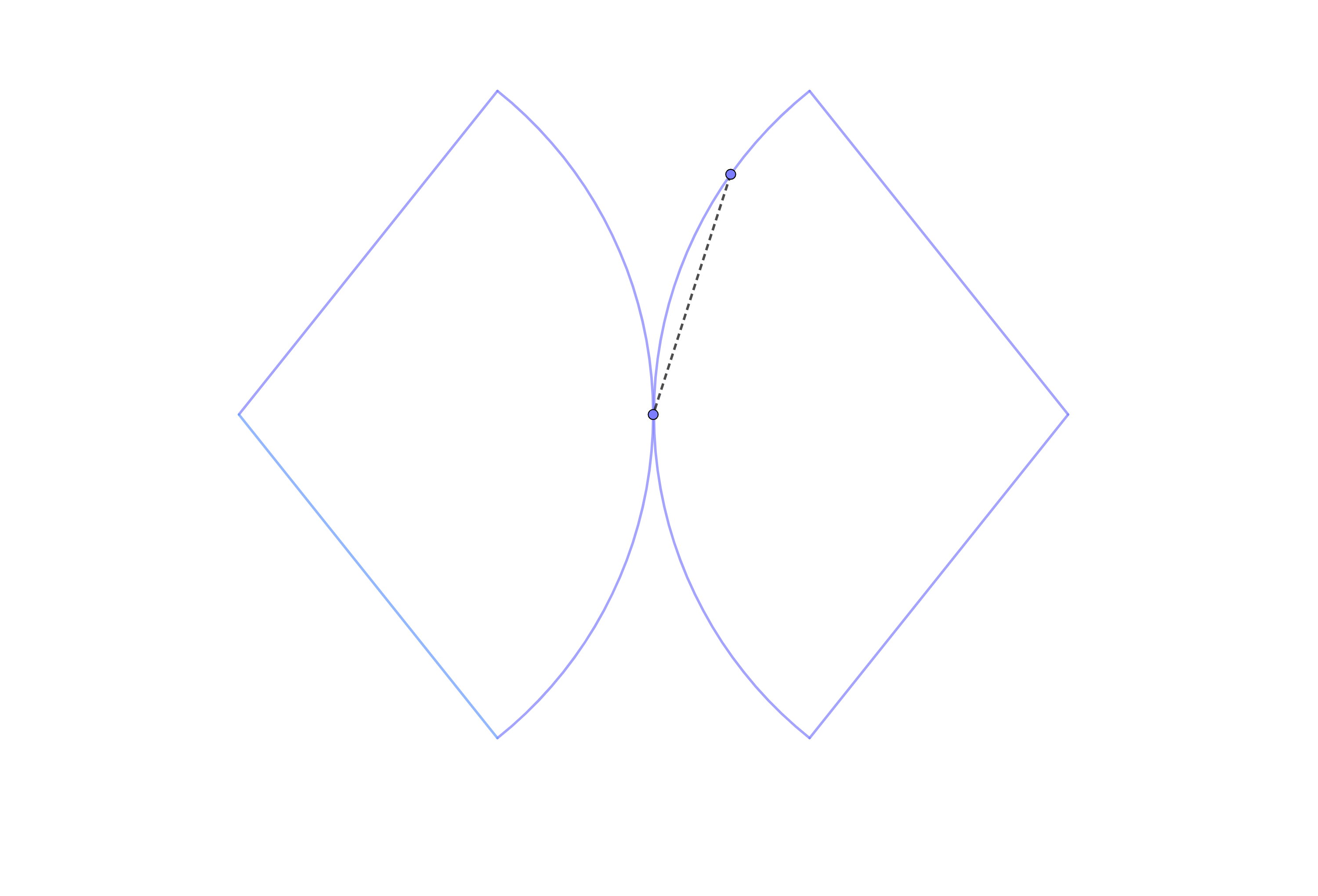

Jeux d'argents et théorie des martingales

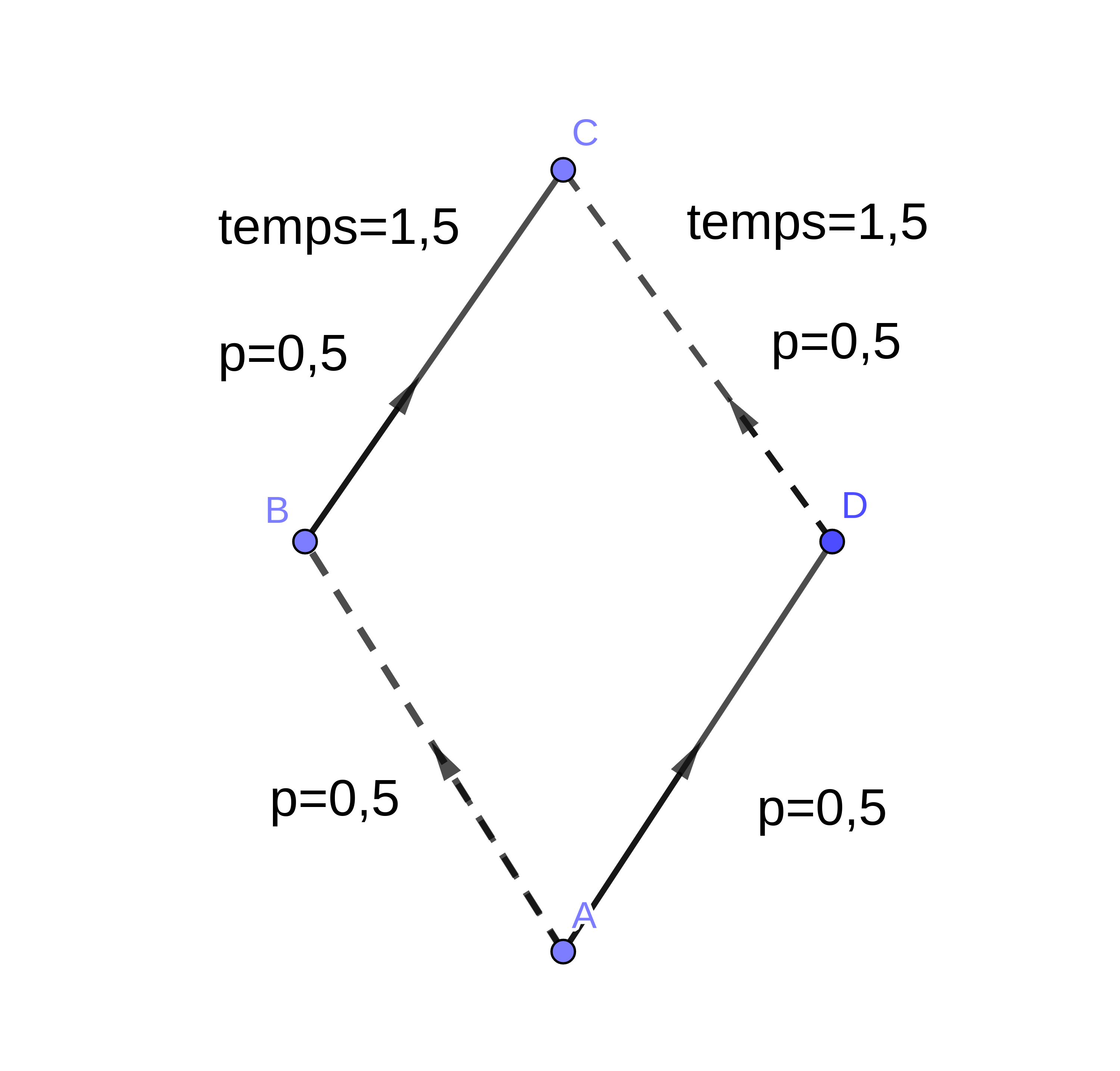

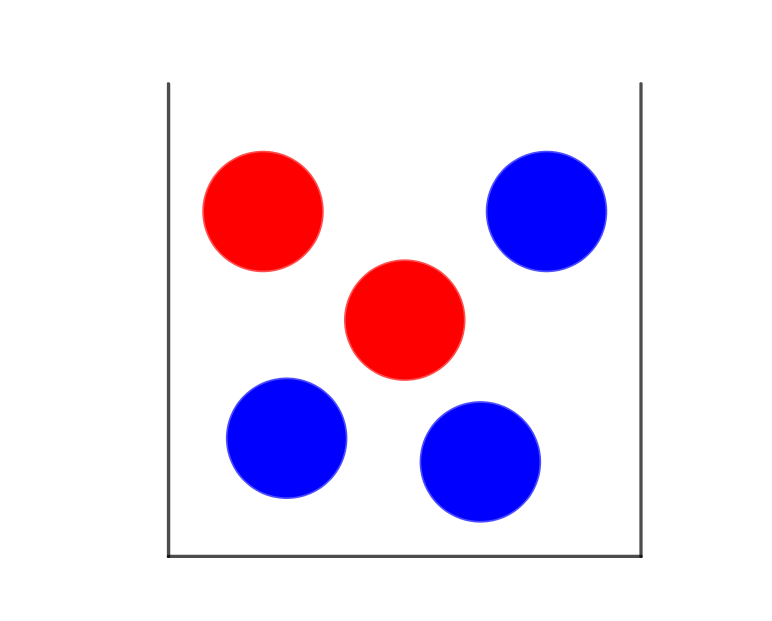

Dans une salle, \(N\) joueurs se réunissent et jouent au jeu d'argent

suivant. À chaque temps deux joueurs sont tirés au sort et ils parient

l'un contre l'autre sur un pile ou face (équilibré). La mise est fixé

à \(r\times\)l'argent du joueur le pauvre avec \(0\leq r\leq 1\). Au temps long

comment évolue le système ?

Une martingale

Comme le jeu est équilibré, l'argent de chaque joueur est une martingale

et on a le très beau théorème «\emph{Une martingale bornée converge

presque surement}». Dans le cas présent, il n'y a qu'un seul comportement

assymptotique possible : tous les joueurs repartent ruinés sauf un

qui rafle toute la mise.

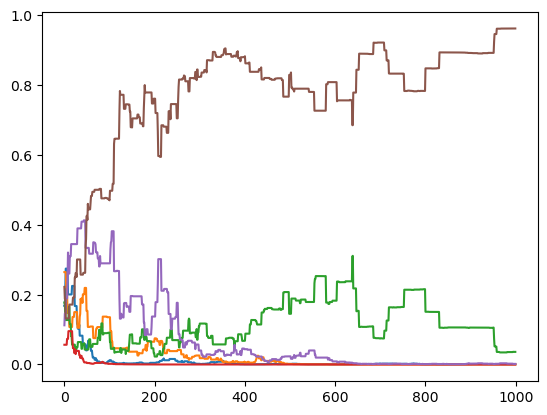

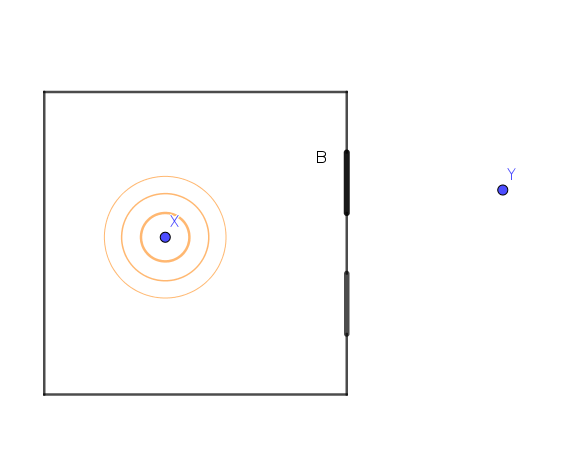

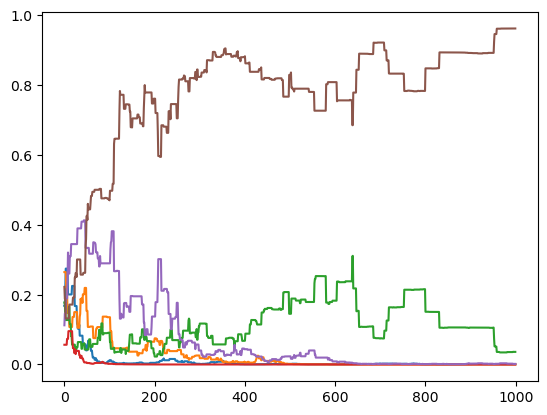

Simulation numérique avec 6 joueurs, \(p=0.3\) et quantitié total d'argent

initiale égale à \(1\).

De plus comme en espérance un joueur ne gagne rien ni ne perd rien,

la probabilité d'être celui qui repart avec toute la mise ne dépend

que de sa mise initiale

\[

\text{Probabilité de gagner = }\frac{\text{argent initial}}{\text{Somme de l'argent de tous les joueurs}}.

\]

Ce qu'il y a de très élégant dans ce résultat c'est qu'il est en fait

complètement indépendant du jeux de hazard considéré. La seule règle

est que le jeu soit équitable. On peut même proposer aux joueurs de

changer de jeux, de choisir leurs adversaires et leurs mises et de

les laisser élaborer des «stratégies». À la fin la conclusion reste

la même : un seul gagnant et avec une probabilité simplement proportionnelle

à la mise initiale.

De l'inégalité parmi les hommes

Naivement on pourrait affirmer que comme le jeu est équilibré il n'a

pas d'influence sur les inégalités. Ceci est bien sur faux au vu du

paragraphe précédent mais on peut proposer un argument plus général.

Une manière usuelle de mesurer les inégalités parmi \(n\) personnes

est de construire un indicateur en utilisant une fonction convexe

\(f\).

\[

I(X)=\sum_{i=1}^{n}f(X_{i})\qquad X_{i}=\text{argent de la i-ème personne}

\]

Pour un exemple réellement en pratique :

\[

\text{Coefficient de Gini =}\sum_{i,j}|X_{i}-X_{j}|

\]

On a l'affirmation suivante : Pour des jeux équilibré, par Jensen

\(I(X)\) est une sous-martingale : en espérance elle augmente à chaque

tirage aléatoire. La morale de la fable pourrait donc être la suivante

: tous les jeux : casino, paris sportifs ou jeu en bourse s'il se

disent «équilibrés» ont pour impact d'augmenter les inégalités.

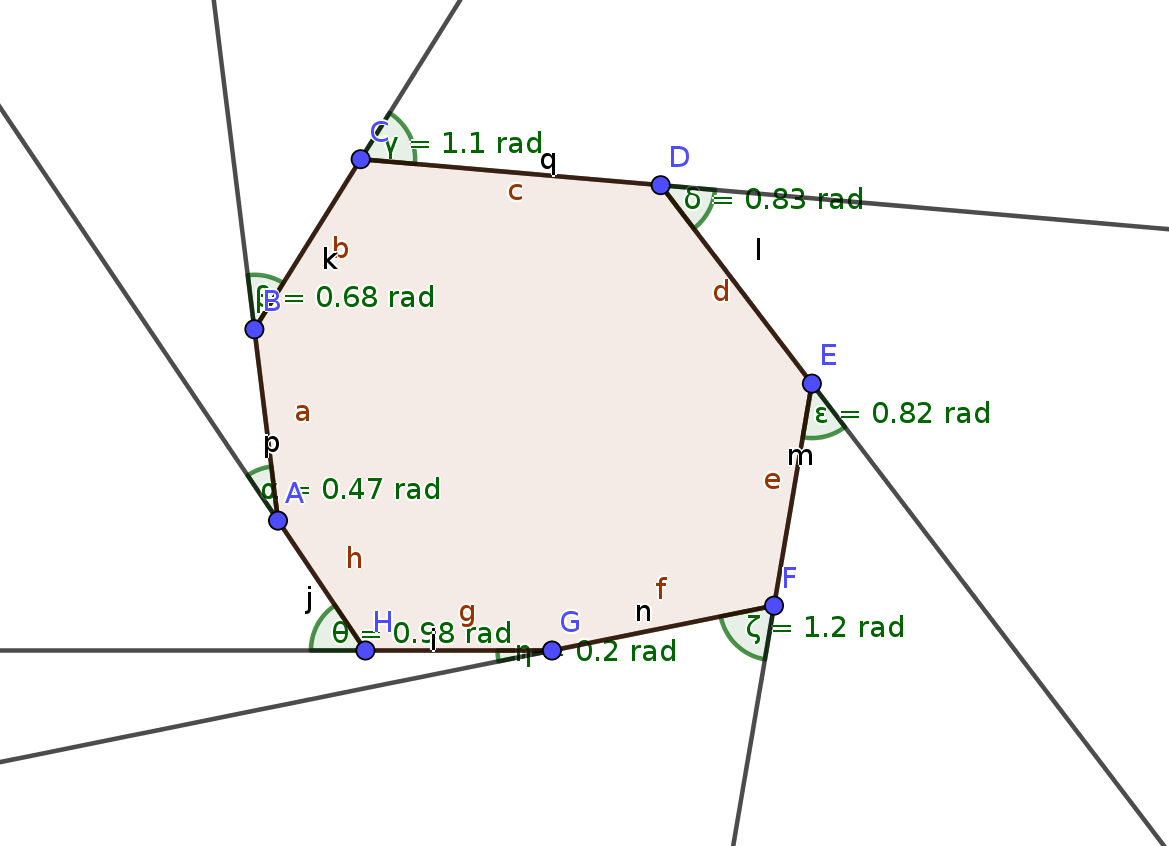

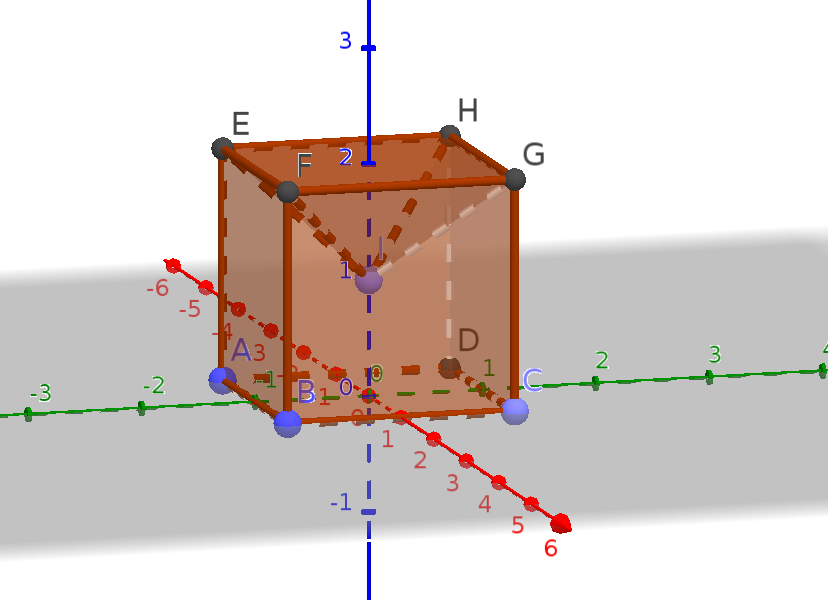

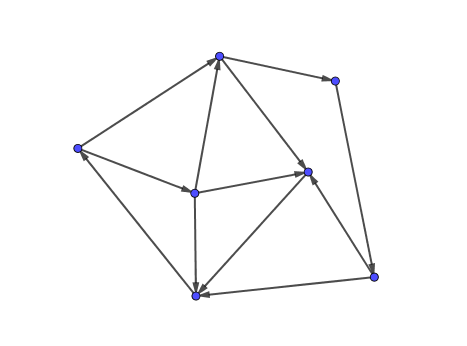

Une simple matrice pour l'inflation

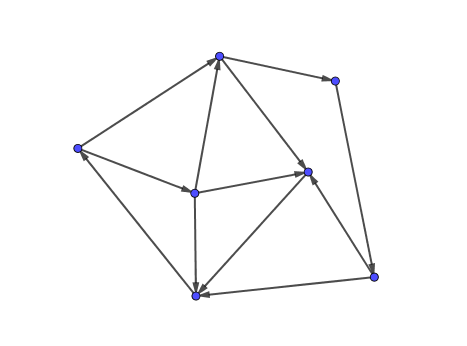

On considère un modèle extrèmement simple pour représenter l'économie.

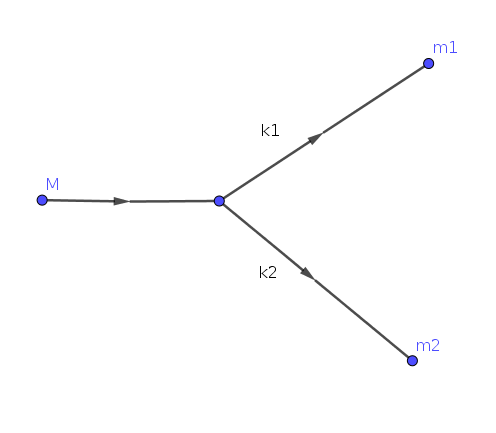

Le tout est un grand graphe orienté \(G=(S,A)\) où chaque «agent économique»

est représenté par un sommet, deux sommets sont connectés si il y

a un «échange commerciale» entre les deux et l'orientation indique

qui est «client» ou «fournisseur».

À cela on ajoute une matrice de réponse \(R\in\mathbb{R}^{S\times S}\)

qui décrit le comportement de chaque agent lorsqu'il est subit à une

hausse de prix. La règle est simple : si l'agent \(i\in S\) voit ses

frais augmenter de \(h_{i}\in\mathbb{R}\), il les répercute proportionnellement

sur chacun de ses clients \(j\) en augmentant ses prix de \(R_{ij}h_{i}\).

On peut regarder ce que donne ce modèle dynamiquement avec un temps

discret. On part d'une situation à l'équilibre et la perturbe avec

une augmentation. À chaque temps, les agents mettent à jour leurs

prix et créent une nouvelle augmentation.

\[

H^{(0)}\in\mathbb{R}^{S}\qquad H^{(n+1)}=RH^{(n)}.

\]

En cumulée, l'augmentation total par rapport à la situation initiale

est alors

\[

C^{(n)}=(I+R+R^{2}+\cdots+R^{n})H^{(0)}\underset{n\rightarrow\infty}{\rightarrow}(I-R)^{-1}H^{(0)}

\]

ce qui donne une formule très simple la réponse au temps long si le

rayon spectral de \(R\) est inférieur à \(1\). Un cas particulier naturel

est justement de supposé \(R\) une matrice stochastique : \(\sum_{j}R_{ij}=1\)

pour tout \(i\in S\) qui correspond pour les agents répercutent l'augmentation

complètement sur leur clients. Dans ce cas au temps long

\[

C^{(n)}\sim n\sum_{i\in S}H_{i}^{(0)}\times u^{R}

\]

où \(u^{R}\) est le vecteur propre de \(R\) associé à la valeur propre

égale à \(1\). Ici les prix augmentent de manière continue et régulière.

Un dernier cas est si \(R\) admet une valeur propre \(\lambda>1\) (si

les agents anticipent la hausse des prix par exemple) on a alors une

inflation qui explose de manière exponentielle.

Pour finir on peut introduire une matrice diagonale \(D=\text{diag}((1-\sum_{j}R_{ij})_{i})\)

qui décrit la proportion de la hausse que l'agent subit effectivement

au temps long on a

\[

D(I-R)^{-1}H^{(0)}.

\]

Le problème de l'inflation tient alors un peu du dilemme du prisonnier

: ce sont ceux qui contribuent le moins à l'inflation (\(D_{i}\) grand)

qui en subissent le plus les conséquences.